Охота на фейки

https://otr-online.ru/programmy/segodnya-v-rossii/ohota-na-feyki-44907.html

Иван Князев: Распознавать фейковые, или фальшивые, новости в России хотят с помощью искусственного интеллекта. Специальный сервис предложили создать в Роспечати уже к 2023 году. Затраты на разработку обойдутся почти в 95 миллионов рублей.

Тамара Шорникова: Правда, пока эксперты не очень хорошо представляют, как именно умная машина будет распознавать фейки.

Вот вы, уважаемые друзья, как отличаете фальшивые новости от настоящих? Каким источникам доверяете, а каким – нет? И почему? Звоните нам прямо сейчас. Мы будем разбираться вместе с экспертами. Интересно в данной связи еще то, не поплатятся ли пользователи соцсетей.

Иван Князев: Ну да, обычные граждане, которые…

Тамара Шорникова: …которые что-то где-то услышали и рассказали просто друзьям. И что, это фейковая новость?

Иван Князев: Да, друзьям переслали, поделились на своей странице в различных соцсетях. Спросим у экспертов.

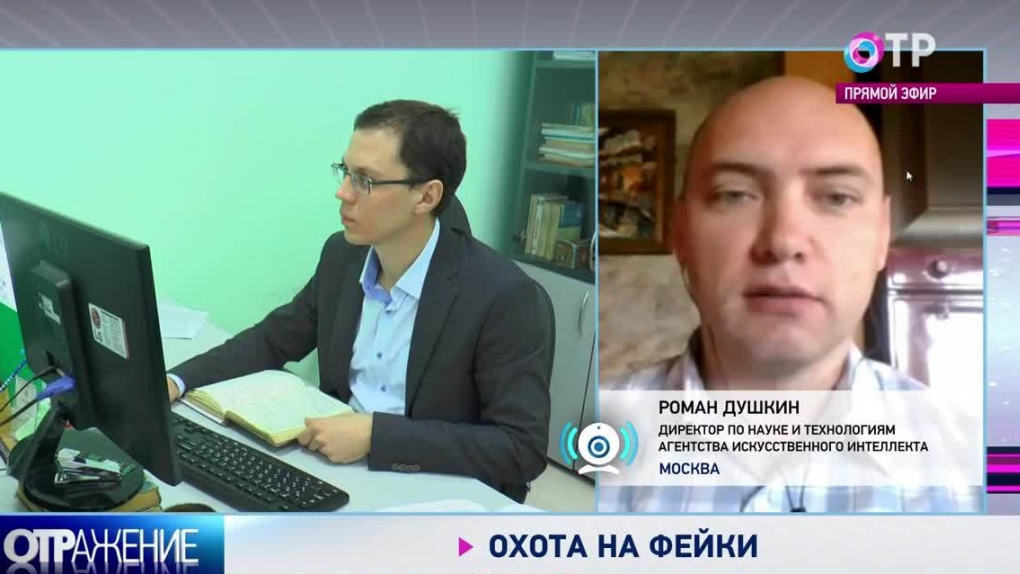

Роман Душкин у нас на связи, директор по науке и технологиям Агентства искусственного интеллекта. Здравствуйте, Роман.

Роман Душкин: Здравствуйте.

Тамара Шорникова: Роман, у Facebook пока не получается, несмотря на огромные бюджеты, что-то подобное такому сервису создать. А Роспечать сможет, да? Какие перспективы? Как будет вообще работать эта система?

Роман Душкин: Ну давайте начнем с того, что, насколько мне известно, Роспечать пока просто подала в Минцифру предложение о том, что надо бы сделать по их направлению, по компетенции их ведомства.

Иван Князев: Пока только денег попросили?

Роман Душкин: Да. Поскольку в России есть целая стратегия развития технологий искусственного интеллекта, все органы исполнительной власти сейчас дают предложения по тому, как они это будут делать. Вот Роспечать предложила такой вариант.

Иван Князев: Ну а чисто теоретически, если порассуждать, как это можно делать? Какие алгоритмы должны работать у искусственного интеллекта? Есть ли у нас и вообще в мире сейчас такие технологии, чтобы распознавать: вот эта новость фейковая, фальшивая, здесь правду/неправду сказали? Это реально вообще?

Роман Душкин: Ну, когда такие вопросы задают мне, я всегда говорю: если человек может это делать, то мы сможем научить и искусственного когнитивного агента делать ту же самую функцию.

Распознавать фейковые новости – ну, это задача достаточно сложная для человека, вы же понимаете. Так просто взять и научить искусственного когнитивного агента искать подтверждение новостям не так просто. То есть задача заключается в том, чтобы находить подтверждение тому, что написано. А это значит – не только авторитетные источники, потому что в авторитетных источниках тоже может быть написана ерунда, но и в принципе знания общего смысла, так скажем. Общий здравый смысл должен быть. А вот эта задача в рамках искусственного интеллекта еще, к сожалению, не решена.

Иван Князев: Понимаете, Роман, эта задача здравого смысла не только у искусственного интеллекта не решена, но и у обычных людей зачастую тоже проблемы с этим бывают.

Тамара Шорникова: Да, вот это утверждение: человек может не всегда. Даже в журналистике фактчекинг – это такая сложная система проверки данных, которая занимает много времени.

Интересен вопрос денег, все-таки давайте вернемся к нему. Только что говорили о том, что Роспечать пока только попросила денег. Какой-то конструкции и понимания о сервисе нет, но при этом есть четкое понимание, что стоить это должно 95 миллионов. Адекватны ли эти деньги? Откуда взялась эта сумма?

Иван Князев: На что они пойдут? Это будет зарплата программистам? Не знаю, это нужно будет закупать какие-то процессоры мощные?

Тамара Шорникова: Суперкомпьютеры.

Иван Князев: Да, суперкомпьютеры.

Роман Душкин: Сложно сказать. Скорее методом вот таким взяли, оценили что-то и предложили.

Самое главное, что здесь можно сказать? Это то, что нейросетевой, чисто нейросетевой подход, скорее всего, не сработает. Именно поэтому у Facebook не получается. То есть обучать большую нейросеть тому, что вот это фейк, а вот это не фейк, в данном случае не поможет, потому что, как бы мы ее ни обучили, всегда найдется более хитрая нейросеть, которая, зная, как обучена эта наша нейросеть, которая распознает фейки или не фейки, сможет нагенерить новые фейки, которая она уже не распознает. Это так называемая проблема состязательных атак в искусственном интеллекте. Это серьезная задача.

Иван Князев: Роман, а что такое нейросетевой подход, если так по-русски разложить и объяснить? Потому что даже вот это сложно уже.

Роман Душкин: Ну смотрите, на пальцах. У нас в голове 86 миллиардов нейронов. Каждый нейрон – это, так скажем, маленький процессор, который может складывать числа, которые пришли ему на вход. Это если очень просто говорить. То есть в каждый такт работы нейрона на вход приходят какие-то числа, он их складывает. И если сумма выше некоторого порога, то нейрон посылает на свой выход тоже какое-то число – ну, например, 1. А если ниже этого порога, то он ничего не посылает – то есть 0.

Иван Князев: Ну, не скажу, что понятнее стало.

Роман Душкин: Ну смотрите…

Иван Князев: Тем не менее, в общем, это будет такой процессор, который будет работать примерно так же, как наш мозг?

Роман Душкин: Нет-нет-нет.

Иван Князев: Или это будет несколько таких процессоров?

Роман Душкин: Эти нейроны объединяются в очень широкую и глубокую сеть. То есть в нашей голове 86 миллиардов таких процессоров, и они все соединены. И вот они работают вместе, в параллельном режиме. И это позволяет нам быть разумными существами.

Само собой разумеется, что 86 миллиардов искусственных нейронов нигде еще нет ни у кого. Но те глубокие нейронные сети, которые уже существуют, там счет идет на миллионы нейронов, поэтому они решают какие-то когнитивные задачи более или менее сносно. В некоторых задачах уже лучше человека. Как бы обольщаться не нужно.

Тамара Шорникова: Давайте послушаем телефонный звонок от нашего телезрителя. Степан из Анапы, у него есть какой-то вопрос, возможно, мнение. Здравствуйте, Степан.

Иван Князев: Здравствуйте.

Зритель: Добрый день.

Тамара Шорникова: Степан, где новости берете? Каким доверяете, а каким – нет?

Зритель: Ну, всего понемножку: и пресса, и телевидение, все каналы. Но лучше всего, конечно, ОТР – так сказать, примерно 60%, фейков меньше. Ну а больше всего – Скабеева. Это практически один фейк. Классика: мальчика за ноги подвешивали. Теперь машина, может быть, вычислит, Скабеевой будет стыдно, и она вообще уйдет с телевидения.

Иван Князев: Степан, ну давайте… Нам как-то несколько неэтично обсуждать, во-первых, наших коллег. А во-вторых, мы не знаем подробности той или иной истории.

Вы как собственное мнение, свое мнение составляете? Вот я, например, если какую-то новость вижу, я стараюсь посмотреть, может быть, на другом источнике, может быть, почитаю комментарии экспертов. Как это вы делаете?

Зритель: Как делаю? Во-первых, есть жизненный опыт.

Иван Князев: Что немаловажно.

Зритель: Это первое. Второе – конечно, сопоставляю разные данные, мнения товарищей, друзей, прессы печатной и телевидения.

Иван Князев: Степан, а как думаете, если этим будет заниматься машина, она сможет это делать? Она сможет быть умнее нас, гуманоидов?

Зритель: Ну, в перспективе, лет через десять, может быть, и сможет. А сейчас, конечно, надо пытаться что-то делать.

Иван Князев: Ну понятно.

Тамара Шорникова: Да, спасибо.

Иван Князев: Спасибо, Степан.

Тамара Шорникова: Вот Степан говорит, что еще лет десять.

Иван Князев: Степана не обманешь.

Тамара Шорникова: А у вас какие прогнозы по времени? И как вы отличаете фальшивые новости от настоящих? У вас какой метод?

Роман Душкин: Ну, насчет лет десяти – я бы так не говорил.

Тамара Шорникова: Побыстрее все-таки, да?

Роман Душкин: Ну да, конечно, побыстрее. Ну смотрите. Я вспоминаю разговор со своим тестем…

Иван Князев: Он у вас тоже отсеивает фальшивые новости? Обычно это так на кухне и происходит, когда с тестем, с тещей…

Роман Душкин: Да-да-да.

Иван Князев: Сразу все выявляется, где правда, а где неправда.

Тамара Шорникова: Это просто настоящий детектор лжи.

Роман Душкин: Вот смотрите. Мой тесть со своим тестем все время смотрели новости на каком-то канале – на Первом или на Втором. Они не пропускали ни одни новости. Я им говорю: «Зачем вы все это смотрите? Это же вас нагружает всем этим негативом, фейками, ерундой». Они говорят: «Мы очень тщательно это все фильтруем. Не думай, что мы такие простецы». Но потом они же в разговоре с деревенскими мужиками все эти вещи, которые телевизор вкладывал в голову, транслировали. И не нужно полагать, что у человека есть очень грамотная система фильтрации всего.

Помните, как говорили древние мудрецы: «Телевидение – это самое главное наше искусство. Почему? Потому. Потому что то, что телевизор вложит в голову – то и будет».

Поэтому то, что Роспечать хочет сделать – это, конечно, надо приветствовать. Главное, чтобы это все было сделано грамотно и на тех методах искусственного интеллекта, которые позволят решить именно эту конкретную задачу.

И что хотелось бы пожелать? Чтобы эта технология не была использована во вред обществу. Вот как-то так, наверное.

Иван Князев: Спасибо, спасибо вам большое.

Тамара Шорникова: Спасибо.

Иван Князев: Роман Душкин был с нами на связи, директор по науке и технологиям Агентства искусственного интеллекта.

Тамара Шорникова: Пишут нам, что доверяют в основном новостям, которые узнали от своих знакомых.

Иван Князев: Свердловская область пишет: «Вообще одно вранье идет у нас в средствах массовой информации». Наверное, конечно же, это не так. Омская область: «Никто ничему не верит уже».

Тамара Шорникова: А вот Москва, как всегда с подозрением относящаяся к различного рода инициативам, пишет: «Все новости неугодные могут стать фейками». Вот эту проблему тоже попробуем обсудить.

Иван Князев: А вот это серьезная проблема, да. Попробуем обсудить ее с нашим следующим экспертом.

Василий Черный у нас на связи, директор по маркетингу Brand Analytics. Василий Анатольевич, здравствуйте.

Василий Черный: Добрый день, здравствуйте.

Тамара Шорникова: Как прокомментируете сначала сообщение от нашего телезрителя? Мол, очень просто будет фильтровать информацию – не фальшивую от настоящей, а удобную от неудобной, скажем так.

Василий Черный: В этом тезисе чувствуется подозрение ко всему, что исходит от государства. И это, с одной стороны, как бы обидно, а с другой стороны, разумно. В этом смысле средства массовой информации должны быть как государственными, общественными, так и частными. Поэтому, возможно, и те средства, подсказывающие нам, сигнализирующие о том, что те или иные новости могут оказаться недостоверными или фейками, тоже не должны быть исключительно под контролем государства. Так ведь? И тогда к подобным алгоритмам, если они будут созданы, будет больше доверия.

Тамара Шорникова: Секунду, уточняющий вопрос. Условно, в соцсетях… Просто по кому это может пройтись катком таким? В соцсетях человек написал общо: «Я считаю, что чиновники воруют». Он подпадает под это? Умная машина отфильтрует его, заблокирует его аккаунт?

Василий Черный: Ну смотрите. Вы просто границы обсуждения немножко размываете. То, что предложила Роспечать не сама, а в ответ на запрос Минкомсвязи… Я думаю, что сама Роспечать не стала бы это предлагать. А уж если ее спросили, там говорят: «Ну, если вы хотите нам помочь в рамках программы искусственного интеллекта, то помогите же нам с фейками». И этот их ответ совершенно логичен. Это раз.

Во-вторых, они имели в виду исключительно проверку новостей, то есть того контента, который создают СМИ. Вы же привели пример очень правильный, который меняет фокус нашей дискуссии, но этот пример касается соцсетей. На самом деле fake news – гораздо большая проблема не для СМИ, в которых вы работаете, в которых…

Иван Князев: И где, в принципе, информацию-то проверяют, так или иначе, редакторы и несут за это ответственность.

Василий Черный: Да, да, да. Поэтому я думаю, что применимо к проверке средств массовой информации это вообще не очень актуальная задача. Ну, можно это обсудить, но она не очень актуальная. Поэтому проверять все, что вы пишете с большими ошибками, потому что эта система будет выявлять желтую прессу, кликбейтные заголовки, все что угодно… Мусора в ее результатах будет гораздо больше, чем пользы. Поэтому сама затея не очень целесообразно выглядит.

А вот смотреть за тем, во что начинают верить люди, что же резонирует в социальных сетях – вот это проблема. Поэтому сама постановка задачи не очень верная. Fake news – это очень большая тема, но часть из них не срабатывают и не вызывают резонанса у людей, люди не верят. Поэтому надо смотреть сначала только на то, что вызвало резонанс, а потом надо отсеивать то, что не является угрозой. Ну, например, если фейк касается котиков – да пофиг! Это никому ничем не угрожает.

И только те темы, которые являются угрозой (как правило, это вопросы политики или денег), вот только по таким темам нам требуется получать сигналы от умных систем – о том, что резонанс в обществе есть, о том, что данный инфоповод надо проверить и как-то отреагировать.

И такие системы сейчас есть, это все уже работает. Собственно говоря, та же наша система, ею пользуется «Сбербанк» и многие другие, получают умные уведомления о проблемных ситуациях.

Иван Князев: Василий Анатольевич, простите, что перебиваю. Здесь очень важный момент. Только ли сигналы будет посылать эта система? Понимаете, у нас за распространение недостоверной информации предусмотрена ответственность. Правильно вы сказали, что в различной степени эта ответственность – в зависимости от последствий, которые после нее случились. Причем ответственность может быть очень и очень серьезная.

Этот искусственный интеллект, этот распознаватель фейковых новостей будет только давать сигналы? Или его можно будет применять в какой-то области права, опираться на его данные и кого-то наказать?

Василий Черный: Я как раз специально разделил этот вопрос. Сигнальная система – это абсолютная реальность, и она фактически уже есть. А если переходить в область права, то без привлечения человека финальное решение доверять искусственному интеллекту на текущий момент и в ближайшие годы вряд ли получится. Мы получим от этого только больше проблем, чем пользы.

Иван Князев: Понятно.

Тамара Шорникова: Да, спасибо.

Иван Князев: Спасибо. Василий Черный был у нас на связи, директор по маркетингу Brand Analytics.

Переходим к следующей теме?

Тамара Шорникова: Да.